© h2

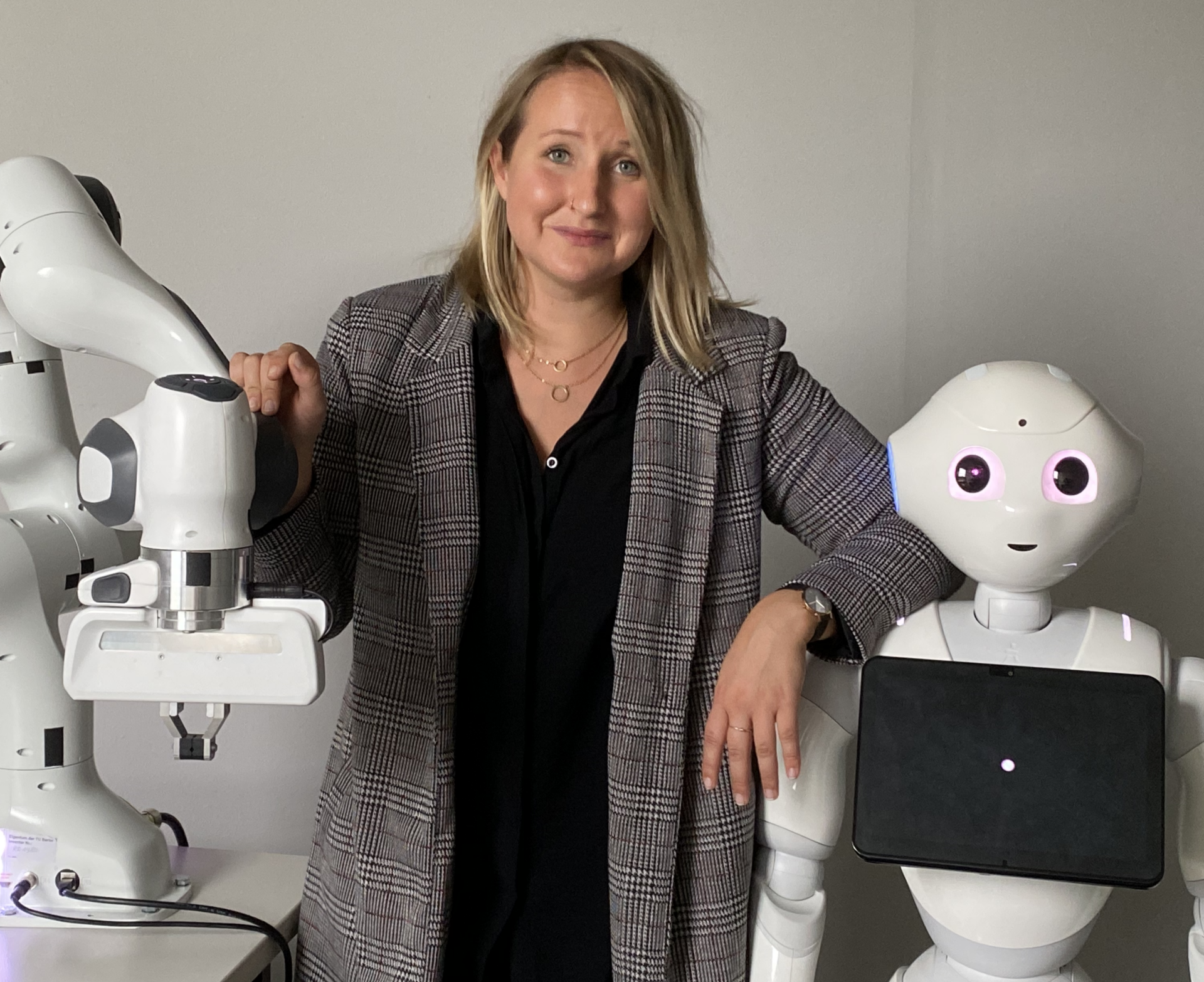

Warum werden KI-Systeme oft als humanoide Robotern dargestellt und welchen Zweck erfüllt dieses Narrativ? In dieser Folge begrüßen wir die Psychologin und Assistenzprofessorin Dr. Eileen Roesler zu Gast, Expertin auf dem Gebiet Mensch-Roboter und Mensch-KI-Interaktion. Aktuell leitet sie ihr eigenes Forschungslabor zu Human-Agent-Collaboration an der George Mason University in Washington DC und beschäftigt sich dabei vor allem mit der Rolle des Menschen. Im Gespräch mit Lena Büscher spricht sie darüber, wie Interaktion sinnvoll gestaltet werden kann, wann Menschen Fehler von Künstlicher Intelligenz „verschlimmbessern“ und warum Erklärbarkeit eine zentrale Rolle einnimmt.

Moderation: Lena Büscher

Schnitt & Text: Julia Fritz

00:00:00 SPEAKER_00

Willkommen bei KI Insights, ein Podcast vom Projekt ZAKI an der Hochschule Magdeburg-Stendal. Hier teilen Expertinnen verschiedenster Disziplinen ihre Einblicke in die facettenreiche Welt der künstlichen Intelligenz. In der zweiten Staffel erwarten Sie Beiträge rund um das Thema Mensch und Gesellschaft im Kontext von KI. Moderiert von Peter Kahn, Lena Büscher und Prof. Dr. Sebastian von Enzberg.

00:00:28 SPEAKER_01

Herzlich willkommen zu unserem Podcast KI Insights. Mein Name ist Lena Büscher und ich begleite Sie heute durch diese Podcast-Folge. Heute werfen wir einen genauen Blick auf das Themenfeld Mensch-KI-Interaktion und welche Auswirkungen diese auf Wahrnehmung und Verhalten hat. Zu Gast habe ich heuer Aileen Rösler, die gerade aus Washington DC zu uns geschaltet ist. Aileen ist Psychologin und Assistenzprofessorin an der George Mason University und forscht dort in ihrem Human-Agent-Interaction-Labor zu Human Factors, in der Mensch-Roboter- und in der Mensch-KI-Interaktion. Liebe Aileen, wie schön, dass du da bist. Möchtest du dich selbst einmal kurz vorstellen? Ja, hi Lena. Ich freue mich auch

00:01:05 SPEAKER_02

sehr, heute im Podcast mit dabei zu sein, weil ich tatsächlich aus der Region, in der ihr gerade seid, also Magdeburg und Umgebung komme. Und ich bin, wie du gesagt hast, Originalpsychologin und habe auch in Leipzig und Dresden Psychologie studiert und bin dann für den Doktor nach Berlin gegangen und habe da auch zum Mensch-Roboter-Interaktion promoviert. Und jetzt bin ich eben hier als Assistenzprofessor bei meinem Lab unterwegs in der Nähe von Washington DC. Und ich freue mich heute zumindest mal digital wieder in der Nähe von Magdeburg zu sein.

00:01:30 SPEAKER_01

Sehr schön, vielen Dank für die kleine Vorstellungsrunde. Deine Forschung beschäftigt sich ja zentral mit Mensch-Roboter-Interaktion und auch mit Mensch-KI-Interaktion. Jetzt kann ich mir vorstellen, dass es für die Zuhörenden unklar ist, inwiefern sich das denn jetzt gleicht oder was für Unterschiede es da gibt. Könntest du uns das einmal näher bringen? Ja, total

00:01:51 SPEAKER_02

gern. Ich behandle das eher als zwei getrennte Forschungsstränge, auch wenn die meisten Leute denken, dass das komplett Hand in Hand geht. Eine Schrauberter-Interaktion beschäftigt sich ganz viel mit der Verkörperung von Systemen und die Wirkung der äußeren Hülle in den physischen Raum. Das ist bei den meisten KI-Systemen, die uns im Alltag entgegentreten, nicht der Fall. Also die weitentwickelten Sachen, die die meisten Menschen, sowas wie zum Beispiel Grammatik-Unterstützungsprogramme wie Grammarly, benutzen, haben keinerlei Körper. Das heißt aber nicht, dass sie in ihrer Wirkung irgendwie eingeschränkt sind. Und ich glaube, dass eine große Misskonsumption ist, die auch in weiten Teilen besteht, dass intelligente Systeme eben diese humanoiden Roboter sind, die möglichst menschähnlich versuchen, uns Aufgaben abzunehmen oder eben auch die Angst davor, uns Aufgaben eben auch langfristig wegzunehmen. Und ich glaube, es ist ganz, ganz wichtig, das klarzumachen, dass eben nicht jedes verkörperte System, also nicht jeder Roboter ist intelligent, bei weitem nicht. Das kann man aus Erfahrung sagen, wenn man mit ihnen im Labor arbeitet. Und nicht jedes intelligente System braucht eine Verkörperung. Die meisten brauchen das übrigens nicht.

00:02:53 SPEAKER_01

das übrigens nicht. Was hast du für Beispiele für ein intelligentes System, das ganz ohne Verkörperung funktioniert? Tatsächlich die meisten, die im professionellen Kontext

00:03:01 SPEAKER_02

Kontext eingebüßt werden. Es gibt zum Beispiel Systeme, die RadiologInnen dabei unterstützen, Grippstrukturen zu entdecken. Es gibt Systeme ganz, ganz viel im Personalbereich, also Personalauswahl, aber auch Personalentwicklung. Es gibt eben die Systeme, die wir oder die meisten Leute vielleicht auch privat nutzen. Das ist alles, was im Bereich der Large-Language-Models, also Chat-GPT ist natürlich ein sehr prominentes Beispiel aktuell, aber eben auch sowas wie Dramalink. Und je nach Aufgabe ist es eben unterschiedlich wichtig, ob man einen Körper hat. Und für die meisten Systeme, die eben sehr fortgeschritten sind, ist eine Verkörperung gar nicht relevant und das würde es auch nur schwerer machen. Weil das beides in Einklang zu bringen, ist eine gigantische Herausforderung. Das beides in Einklang zu ist eine gigantische Herausforderung. bringen, Also die meisten die aktuell sehr gut laufen oder sehr fortgeschritten sind in ihrer Technologie, Systeme, sehr, sind tatsächlich digitale Systeme und Interfaces ohne Verkörperung.

00:03:58 SPEAKER_01

Man braucht keinen Roboter, der in einen Computer tippt, um Output zu bekommen, der getippt wird. Total. Ich finde an dem, was du gerade erzählt hast, auch besonders interessant, dass die Bilder, die man so sieht von KI oder auch wenn man irgendwas generieren lässt, immer ein Mensch ist, der mit einem Roboter spricht oder ein Roboter, der vor einem Computer sitzt, wo dann nochmal das neuronale Netz irgendwie im Gehirn dargestellt ist. Aber es ist immer dieses Verkörperungsniveau ganz explizit dargestellt, obwohl das ja im Alltag eigentlich gar nicht so ist, wie wir gerade gelernt haben. Ja, und das ist aus einer psychologischen Perspektive relativ

00:04:27 SPEAKER_02

Perspektive relativ interessant. Also ich mache auch Forschung zur Mensch-Ähnlichkeit in der Mensch-Roboter-Interaktion. Wenn wir Systeme referieren, die wir nicht kennen, wollen wir Metaphern verwenden, die uns sehr gut bekannt sind. Deshalb werden eben auch neuronale Netze direkt mit dem menschlichen Gehirn in Verbindung gesetzt, also als Abbildung, obwohl das eben nicht aussieht wie die Masse, die wir am Schädel haben. Bei Robotern ist das eben ähnlich. Die meisten Roboter, die man findet, haben überhaupt nichts menschähnliches oder sehr wenig menschähnliches. Hier zum Beispiel über den Campus fahren so kleine Boxen, in denen Essen transportiert wird. Die sind hier total beliebt. Sie werden in jedem Fall als Marshmallows referenziert. Und das sind eben Roboter, die uns auch im Alltag begegnen, die also nichts mit Menschlichkeit zu tun haben und eben sehr funktional sind. Wenn wir aber Metaphern für etwas brauchen, was vielleicht noch unbekannt ist, dann nutzen wir gern etwas, was eben sehr nah ist am Menschen, weil es das ist, was wir intuitiv am meisten überlernt haben. Diese Misskonzeption kann fatale Folgen haben und kann auch dazu führen, dass eine gewisse Angst vor Systemen entsteht auf Basis dieser Ähnlichkeit, die vielleicht gar nicht gegeben ist. Und das ist vielleicht auch eine sehr schöne Überleitung zu Mensch-KI-Interaktion, denn anstelle, dass wir den Menschen perfekt ersetzen wollen in seinem Entscheidungsverhalten,

00:05:45 SPEAKER_02

sollte es viel, viel wichtiger sein, dass wir Systeme entwickeln, die den Menschen erlauben, bessere Entscheidungen zu treffen. Also das sollte aus einer psychologisch und menschenzentrierten Perspektive wirklich das Ziel sein.

00:05:57 SPEAKER_01

Da sind wir dann auch im Bereich Ko-Kreation irgendwie als großes Ziel von KI-Mensch-Interaktion. In deiner Forschung interessiert dich ja vor allem die Komponente Mensch in der Mensch-KI-Interaktion. Mich interessiert an der Stelle besonders zum Einstieg, woran du in deiner Forschung menschliches Verhalten überhaupt festmachst, ob es das Nutzungsverhalten ist, ob eine KI angenommen wird oder nicht. Ich glaube, du hast schon wichtige Punkte

00:06:26 SPEAKER_02

Punkte angeschnitten, weil Dichotome ist also Null- und Einsverhalten. Also ob man etwas wirklich nutzt, ist total relevant. Aber das vor allem, wenn man die Wahl hat, ob man es nutzt. Was mich auch interessiert, ist, was ist denn, wenn Entscheidungssysteme implementiert werden und dass sie implementiert werden, steht gar nicht zur Debatte. Also wir werden eine Interaktion haben. Was passiert, wenn große Firmen beispielsweise, ich bleibe mal kurz beim Beispiel, Personalauswahl in große Firmen bei KI implementieren? Übrigens auch total interessant, wenn man aus Deutschland und Europa kommt und dann in die USA zieht, wo viel mehr bereits implementiert ist, weil es einfach eine komplett andere rechtliche Grundlage gibt. Also wenn wir bei dem Beispiel Personalauswahl bleiben und mir zum Beispiel ein System hilft, Daten zu analysieren, also große Datenmengen zu analysieren und eben zu kritisieren, also vorherzusagen, okay, ob die Person, die sich beworben hat, in der Zukunft gut arbeiten wird. Und jetzt bin ich daran interessiert, okay, wenn diese Zusammenarbeit tatsächlich stattfindet, also ich bekomme eine Empfehlung des Systems, wie verändert sich mein Verhalten und warum verändert sich mein Verhalten in einer gewissen Art und Weise. Deshalb würde ich sagen, das Verhalten, was mich hauptsächlich interessiert, ist nicht Nutzung oder Nichtnutzung, sondern in der Nutzung, wie sehr rücken Menschen den Empfehlungen und vor allem, und das ist ein ganz altes Thema in dem Bereich, in dem ich forsche, was machen Menschen, wenn die Empfehlungen nicht gut sind. Weil das ist das, wo ja der Mensch eigentlich die interessante Komponente wird, wenn Empfehlungen von dem System nicht perfekt sind.

00:07:51 SPEAKER_01

Vielen Dank, das war sehr eindrücklich. Hast du in deiner Forschung denn bestimmte Bereiche, wo ihr die Effekte ganz genau sehen konntet? Also wir haben gerade ein relativ großes Forschungsprojekt, was auch noch

00:08:02 SPEAKER_02

großes Forschungsprojekt, was auch noch in Berlin Studien laufen und hier auch tatsächlich vor Ort schon. Das befasst sich mit einem der großen Trendthemen, würde ich sagen, im Moment. Und das ist Explainability, also Erklärbarkeit in der Mensch-Ka-Interaktion. Und das ist, glaube ich, was ich auch für die ZuhörerInnen, glaube ich, ganz interessant finde, weil das von einer psychologischen Perspektive jetzt erstmal sehr intuitiv ist, dass es eine gute Idee ist, Systeme erklärbarer zu machen. Ich definiere das, oder definieren ist zu viel gesagt, ich würde das auch mit Kurz-Erklärbarkeit erklären. Also grundlegend sind KI-Systeme Blackboxen für Menschen. Wir wissen nicht, warum sie machen, was sie machen und warum sie in manchen Sachen besser sind als in anderen. Was aber klar ist, ist, dass wenn ich mehr Lerndaten habe, ich in dem Bereich besser bin als System, oder als Mensch übrigens, als in anderen Bereichen. Das heißt, Erklärbarkeit kann zum Beispiel da ansetzen, zu sagen, hey, die KI ist besonders gut in dem und dem Fall und hat ein bisschen Probleme in dem und dem Fall, weil es einfach aufgrund der natürlichen Vorkommen von Fällen viel, viel mehr Beispiele in dem Fall. Ich will es mal kurz plakativ machen. Wir nehmen ein autonomes Auto mit einem intelligenten Redaktionssystem für andere Autos. Und jetzt sagen wir, dein Auto ist super gut darin, schwarze, rote Autos zu erkennen, aber wenn das Auto eine sehr untypische Gold, Gold ist bestimmt eine sehr untypische Autofarbe, wenn es Gold ist und shiny damit auch noch,

00:09:26 SPEAKER_02

dann hat deine KI damit Probleme. Und jetzt würde man sagen, ist hey, doch total smart,

00:09:32 SPEAKER_02

weil die abgelenkte Person in diesem hochautomatisierten Auto dann eben, sobald sie goldene Autos sieht, das selten vorkommt, viel mehr Aufmerksamkeit darauf. Und die Form von Erklärbarkeit haben wir uns mal angeguckt. In einem komplett anderen Paradigma, was sehr viel näher am medizinischen Bereich ist, als an autonomen Autos. Aber ich finde, das ist ein ganz gutes, illustratives Beispiel. Und was wir gemacht haben, ist, wir haben Menschen verschiedene Fälle gezeigt. Das sind Bakterienbilder und man schätzt, wie viel in einer Petrischale infiziert ist bei den Bakterien und wie viel nicht. Und das Interessante ist aber, wir haben Leuten gesagt, das System, was dich unterstützt, hat eben mit einer Sorte mehr Probleme, weil es einfach viel seltener vorkommt, dass das System gefunden wird und damit weniger Lerndaten. Und da haben wir was Interessantes gefunden. Die Menschen lernen besser mit dem System aus einem sehr ironischen Grund. Sie fangen einfach an, da wo sie wissen, dass das System besser ist, mehr zu folgen. Das heißt, wenn ich weiß, hey, bei pinken Bakterien ist mein System super gut, dann bleibe ich viel näher an der Empfehlung. In den Fällen, wo aber eigentlich das menschliche Verhalten am relevantesten wäre, nämlich in der, wo es Probleme gibt, da verschlimmen besseren Menschen. Und das ist halt, also es ist so ein herrliches deutsches Wort, dass wir es sogar in englischen Veröffentlichungen mit eingeführt haben. Also ich finde, das ist ein interessantes Ergebnis, weil wenn du den Menschen dann zum Beispiel,

00:10:49 SPEAKER_02

blaue Bakterien ist in meinem fiktiven Beispiel, gibst und damit hat die KI Probleme, sagst, ja, aber das heißt natürlich dass es super schlecht ist. selbst, nicht, Wir würden nie Systeme implementieren,

00:11:00 SPEAKER_02

die eine Null-Prozent-Elektion haben oder komplette Abweichung. Und die Menschen merken nicht wirklich unter Umständen, wo die Fehler vorliegen und wo nicht. Und damit machen sie die Fälle, in denen die KI bereits sehr, sehr gute Leistungen macht, noch schlimmer. Und das ist schade, weil ich finde, es sehr gut zeigt, dass Systeme oft entwickelt werden, ohne den Menschen wirklich ein Bild zu haben. Mensch-KI- Interaktion ist teilweise ebenso prominent, weil wir den Menschen aus rechtlichen Gründen mit drin haben müssen, also weil der Mensch die finale Entscheidung treffen muss. Aber dann designen wir teilweise Systeme, die überhaupt nicht fair sind, um den Menschen bei einer akkuraten Informationsaufnahme und Entscheidung zu unterstützen. Und das heißt sogar Explainability, etwas, was unheimlich gut gemeint ist, wo sich so viele Menschen einig sind, dass Erklärbarkeit und Transparenz einfach eine sehr gute Idee ist, kann negative Effekte haben.

00:11:47 SPEAKER_01

Ich finde das Beispiel oder die Studie, die du uns berichtet hast, zeigt ja ganz gut, dass diese Idee von Synergie Mensch und KI, der Mensch gleicht das aus, was die KI nicht so gut kann, dass diese ja wirklich sehr, sehr schöne Idee irgendwie in der Praxis nicht so wiederzufinden ist. Das ist die große Herausforderung.

00:12:08 SPEAKER_02

Oft werden Systeme entwickelt, die vor allem für eine Sache streben. Und das ist möglichst hohe Leistung. Wir wollen Systeme, die möglichst perfekt sind. Und das ergibt Sinn. Da, wo das System eben diese zwei, drei, vier Prozent, wo das System nicht perfekt ist und zum Beispiel was wirklich Dramatisches übersieht, da wollen wir, dass der Mensch reagiert. Aber wenn die Systeme bereits so perfekt sind, was ist denn die Rolle des Menschen? Und das ist total alte Forschung schon in der Mensch-Automations-Interaktion. Das Problem ist oft, dass wenn wir sehr gute Systeme haben, was wir wollen, und den Menschen aber drin lassen, dass der in eine komplett neue Rolle switcht, nämlich anstelle von einer wirklich aktiven Entscheidung und einer wirklich aktiven Informationssuche wird der Mensch zu so einer Art überwachender Instanz. Also ich werde eher überwachend. Und wenn wir einsetzen müssen aus unserer ganzen langen Forschungskradition, dann dass Menschen nicht gerade besonders gut in Daueraufmerksamkeit und Überwachungsaufgaben sind. Und da machen wir gerade in der Mensch-KI-Interaktion, würde ich sagen, die gleichen Fehler, die wir schon in den, keine Ahnung, 1970er Jahren gemacht haben, als die ersten automatisierten Systeme menschenzentrierter gestalten kann, ohne unbedingt die Leistung des Systems reduzieren zu müssen. Das ist eine große Herausforderung, wirklich bei einer Synergie zu landen. Ich fände es

00:13:30 SPEAKER_01

fände es total spannend, wenn du noch näher darauf eingehen könntest, wie so eine Interaktion besonders synergetisch gestaltet werden kann. Da gibt es ganz viele Ansatzpunkte.

00:13:39 SPEAKER_02

gibt es ganz viele Ansatzpunkte. Es ist immer wichtig zu sagen, es gibt ganz viele unterschiedliche Ansatzpunkte. Ich glaube, manchmal ist kein schlechter Ansatzpunkt, den Menschen tatsächlich aus der Interaktion rauszunehmen. Also anstelle zu sagen, hey, hier ist dein System, es macht die ganze Zeit Sachen und du musst mehr oder weniger immer absegnen und du bist auch am Ende, bist du auch wirklich komplett verantwortlich für die Entscheidung, aber das System ist ja eigentlich sogar viel besser als du. Deine eigene Rolle wird dir nicht mehr wirklich komplett klar. Also Menschen rausnehmen und vielleicht eher sogar einen Abgleich machen mit dem System. Also anstelle zu sagen, hier, du kriegst immer die Empfehlung vom System, einfach mal den Menschen selbst komplett entscheiden lassen und nur wenn es zu einer Abweichung zwischen Systemen, was parallel läuft, kommt, dann tatsächlich irgendwie zu reagieren und vielleicht noch ein anderes Augenpaar drauf schauen zu lassen. Das klingt so unpsychologisch zu sagen, ja, wie wäre es denn, wenn wir den Menschen rausnehmen? Aber ich glaube, in manchen Interaktionen wäre es fair, die Menschen rauszunehmen und ihnen auch eine Leine entscheiden zu lassen. In anderen Fällen können Entscheidungsunterstützungssysteme fantastisch sein, eben auch die menschlichen Kompetenzen in den Vordergrund rücken. Und das ist eine der großen Fragen, die wir ja auch in dieser ganzen Debatte haben. Welche Aufgaben sollten wir abgeben und welche Aufgaben sollten wir behalten? Und ich glaube, das ist eine Auseinandersetzung, die nicht rein technikgetrieben sein sollte. Also wir sollten nicht, und das ist eben auch schon ein Fehler, der so eine lange Forschungskreditum hat, wir sollten nicht die Aufgaben, die übrig bleiben, auf den Menschen legen, sondern wir sollten uns erst Gedanken machen, hey, welche Aufgaben sollten denn bei Menschen unbedingt verbleiben und dann unser System entwickeln. Und da sind wir, wir sind bis heute nicht da. Es sind Erzählungen, die wir halt schon aus den 1950er Jahren bereits kennen, wo die große Frage ist, okay, welche Aufgaben werden wo verteilt, wie dynamisch ist diese Aufgabenverteilung. Da sollten wir mit Zunahme von technischen Systemen in unserem Alltag erst über den Menschen nachdenken und dann über das System. Das ist aber eine Utopie aus dem Wissenschafts-Bubble, die ich hier gerade vorstelle. Ich glaube aber, dass das Verhaltenskonsequenzen haben würde, die sehr positiv sind.

00:15:43 SPEAKER_01

Ja, vielen Dank für die spannenden Einblicke. Ich habe mich gerade gefragt, wo wir beim Thema menschzentrierte Perspektive sind und Mensch-KI-Interaktion, inwiefern die Forschung sich auch von der Mensch-Mensch-Interaktion irgendwie beeinflussen lässt, welche Lessons learned wir mitbringen? Eine sehr, sehr gute Frage und auch da

00:16:03 SPEAKER_02

Frage und auch da wieder, wir haben vorhin ja kurz über die Metapher, die wir oft verwenden, geredet. Also dass eben technische Systeme oftmals wie Menschen charakterisiert werden. Und das ist nicht nur so rum der Fall, sondern sie werden eben auch wie Menschen behandelt. Also es gibt wunderbare Forschung zu, die zeigt, dass Menschen selbst auf Computer, die nun wirklich keine menschenähnlichen Eigenschaften im Aussehen haben oder im Kommunikationskanal per se, dass die bereits vermenschlicht werden. Das heißt, ich schreibe auch Technologien eine gewisse Menschlichkeit zu. Da wird es interessant, inwiefern sich vor allem Mensch-Technik-Interaktion von Mensch-Mensch-Interaktion unterscheidet. Und das gibt ganz viele Sachen, die tatsächlich ein Stück weit vergleichbar sind. Also wir nehmen zum Beispiel Konzepte, die wir gut aus der Mensch-Mensch-Interaktion kennen und übertragen, wie auf die Mensch-Roboter-Interaktion oder auf die Mensch-KI-Interaktion. Aber das geht eben nicht mit allen Konzepten. Und ich möchte das vielleicht kurz an dem alten, sehr schönen Forschungs-, also alt ist in unserer Domäne halt nicht wirklich alt, sondern so um die 2000er Jahre,

00:17:10 SPEAKER_02

an etwas wo diese Metapher illustrieren, eben ihre Probleme kriegt. Und das ist das Konzept von Vertrauen. Vertrauen ist ein sehr intuitives Konzept für Menschen. Also jeder kann sich was darunter vorstellen. Ich vertraue dir zum Beispiel gerade, dass der Podcast so zugeschnitten wird, dass ich damit zufrieden bin. Und jetzt kann ich das Ganze natürlich monitoren und mir nochmal angucken und mein Verhalten eben basierend auf meinem Vertrauen unter Umständen anpassen. Und jetzt ist die Frage, okay, wiefern unterscheidet sich denn Mensch-Mensch- Vertrauen zu Mensch-Technik oder Mensch-Kai-Vertrauen? Da gibt es ein sehr, also für unsere Domäne, ein eher klassisches Konzept und das ist das sogenannte Perfect Automation Stream, also perfekte Automation. Und das hat in den 2003 rum, ist das bekannt geworden und hat Folgendes gesagt. Grundlegend vertrauen wir Technologien mehr als den Menschen, weil wir wissen, dass Menschen fehlbar sind. Also wir wissen, wir kennen Menschen sehr gut, die machen unterschiedliche, sind unterschiedlich gut in ihren Aufgaben, aber bei weit machen sie keine repetitive, perfekte Performance, wie das zum Beispiel technische Systeme haben könnten. Das ist so intuitiv und wurde auch in der Forschung ein Stück weit gezeigt, dass alle so waren, ja klar, macht total Sinn. Also es macht total Sinn, dass ich Menschen weniger vertraue als Systemen und wenn aber ein Fehler passiert, dass ich verzeihender bin gegenüber Menschen als technischen Systemen. Und jetzt haben wir aber in so vielen Studien gefunden, dass es überhaupt nicht der Fall ist. Also wir haben in mittlerweile unzähligen Studien gefunden, dass es überhaupt nicht der Fun ist. Also wir haben in mittlerweile unzähligen Studien gefunden, dass KI-System weniger vertraut wird als menschlichen Expertinnen. Und wir haben immer gedacht, okay, wie geht denn das mit dem Perfect Automation Scheme zusammen? Das sind wirklich nur Forschungshistorische Sachen. Dieses Originale,

00:18:34 SPEAKER_00

Das sind wirklich

00:18:38 SPEAKER_02

diese Originale, sehr intuitive Vorstellung basiert darauf, dass Menschen ohne Expertise fehlbar sind. Das heißt, wenn ich zum Beispiel in einer Aufgabe wie einer Radiologieaufgabe Unterstützung von dir kriege oder du von mir, dann ist es auch irgendwie klar, dass ich uns weniger vertraue. Also, weil was ist denn unsere Expertise? Wenn ich aber eben eine Radiologin habe oder eine Person, die auf jeden Fall mehr Expertise hat als ich, und dafür muss man nicht mal Medizin studiert haben, dann vertraue ich der Person natürlich mehr. Das ist interessant bei gleichem Verhalten auch mehr als einer KI. Das heißt, man hat eigentlich viel mehr einen Imperfect Automation-Skene, weil wir menschlichen ExpertInnen mehr vertrauen und das wird interessant, wenn wir uns Systeme angucken, die extrem gut sind. Da wollen wir eben unter Umständen Hörbus, also das klingt so ungewöhnlich, weil überall dargestellt wird, hey, vielleicht sollten wir irgendwie schaffen, dass Leute eben kein Übervertrauen haben in intelligente Systeme. Aber vielleicht ist das Übervertrauen gar nicht das große Problem, sondern unter Umständen eben Untervertrauen, das ist ein bisschen komisch, wenn man das so sagt, und damit vielleicht die nicht ausreichende Nutzung von Systemen. Wir haben letztens hier vor Ort, und das ist jetzt zum Beispiel mal gar nicht wissenschaftlich, ich bin ja auch in der Gruppe, die eben an das ist zu viel gesagt, Regeln, aber den Umgang mit generativen künstlichen Intelligenzen, generative unter Studierenden arbeitet. AI, Also wie wollen wir als Lehrende auch damit umgehen, dass unsere Studierenden AI nutzen?

00:20:04 SPEAKER_02

Und jetzt kann man da sehr unterschiedliche Herangehensweisen haben, basierend auf einfach dem Konzept, was man selbst davon hat. Man kann es verbieten, wenn man möchte, ist jetzt nicht so einfach nachzuvollziehen, aber man kann es eben auch so ein bisschen, und das ist mehr mein Ansatz, die Leute dazu auffordern, es zu nutzen. Also wir leben in einer Zeit, in der diese Systeme sehr disruptiv waren, also die Einführung war ziemlich in genau, einem Jahr und ein bisschen. Concept-Subjective sehr disruptiv Also waren. die Einführung von ungefähr ziemlich genau und im Jahr und ein bisschen. Concepts-Subjektiv war selbst disruptiv und hat viel verändert. Und unsere Studierenden haben aber teilweise total Angst, das zu benutzen. Also es gibt eine relativ große Kohorte unserer Studierenden, und ich möchte nur für diese kleine, kleine Befragung sprechen, die wir hier kurz gemacht haben, die nicht repräsentativ ist. Aber ich war davon überrascht, wie viele Leute das nie genutzt haben. Sie dachten, es ist Schummeln, es ist nicht in Ordnung, künstliche Intelligenz zu benutzen. Und die Wahrheit ist, gerade hier haben wir ganz viele, ich selbst ja auch, Leute, die nicht MuttersprachlerInnen sind. Und ich denke mir die ganze Zeit so, nein, nutzt es unbedingt. Also nutzt unbedingt Remedy, nutzt unbedingt ChatGPT, um Sachen zu überarbeiten, weil das, was wir halt ganz oft nicht, also ich möchte nicht wissen, was euer Sprachniveau ist, das ist nicht, was ich prüfe persönlich. Ich möchte wissen, ob ihr Konzepte verstanden habt, ob ihr Forschungsmethoden verstanden habt, das sind Sachen, die mich interessieren. Also auch wenn ihr Bewerbungen schreibt oder Ähnliches, nutzt diese Tools für das, was sie können. Verwartet nicht, dass sie inhaltlich perfekte Antworten geben. Also dafür sind sie nicht da. Aber sie werden euch wirklich dabei unterstützen, dass es besser klingt. Und das ist vielleicht was, was unsere Forschung zeigen kann und was eben wirklich menschenzentriert wäre. Also ich sehe unsere Aufgabe auch darin, dass wir es irgendwie schaffen, Leuten beizubringen, intelligente Systeme zu ihrem Vorteil zu nutzen, ohne dabei blind zu vertrauen oder blind zu folgen. Also ich glaube, es ist eine ganz große Herausforderung, die wir alle haben. Wie schaffen wir es, dass Leute eben diese Systeme nutzen können, um das Beste aus ihrer Arbeit zu machen? Und ich habe da wirklich auch viel Hoffnung. Also ich habe auch wirklich ganz viel Hoffnung, dass wir diese Systeme positiv nutzen können. Aber eben gar nicht nutzen ist auch keine Option.

00:21:59 SPEAKER_01

nutzen ist auch keine Option. Total. Was du beschreibst bei den Studierenden, erleben wir in unserem Hochschulalltag hier in Magdeburg auch, dass die Hemmnis, das tatsächlich anzuwenden und auch zuzugeben, das tatsächlich anzuwenden, noch sehr, sehr groß ist. Und viele Fragen, gerade Fragen von Vertrauen, Erklärbarkeit, was kommt da überhaupt raus, einfach noch total unklar sind und dass eben die Nutzung sehr, sehr beeinflusst da. Vielleicht von meiner Perspektive ganz wichtig zu sagen, ich sage nicht,

00:22:30 SPEAKER_02

ich sage nicht, man kann dieses System falsch nutzen. Wenn man nicht genug Expertise in einem Feld hat und nicht weiß, ob das, was das System ausgeht, richtig oder falsch ist, sollte man die Finger davon lassen. Also wirklich, wenn man nicht weiß, ob das, was da steht, inhaltlich korrekt ist, dann um Gottes willen, schreibt es nirgendwo rein. Wenn ihr aber inhaltlich fit genug seid, und das seid ihr, also sind alle in den Domänen, in denen sie eben tatsächlich was machen, dann nutzt das. Klingt nicht nur besser, sondern es kann eben auch ein bisschen die Struktur unter Umständen von Dingen verbessern. Warum soll es 20 Minuten dauern, eine E-Mail zu formulieren. Wenn ich das da relativ rough reintippen kann mit, hey, kannst du mir das kurz ordentlich formulieren? Also es ist eine persönliche Assistenz, zu der wir jetzt alle auch einmal Zugang haben. Also ich glaube, man sollte das nutzen, vor allem, weil es eben auch Arbeit, also die relevante Arbeit erleichtern kann und mehr Platz für das schaffen kann, wo man eben auch die menschlichen Fähigkeiten und Fertigkeiten braucht.

00:23:29 SPEAKER_01

Da hast du ein sehr, sehr schönes Beispiel auch für eine gelungene Synergie, wenn es denn so gelingt, zwischen KI und Mensch und ihrer Interaktion mitgebracht. Ich würde abschließend gerne von dir wissen, was du dir für, also was deine Fantasie oder deine Hoffnung für die weitere Entwicklung und Implementierung von KI, insbesondere in der menschenzentrierten Implementierung von KI, in den nächsten Jahren wünscht.

00:23:59 SPEAKER_02

für was wir schon kurz besprochen haben. das, Ich hoffe darauf, dass nicht Technik nur entwickelt wird, weil wir sie entwickeln können und weil wir dazu in der Lage sind, technologisch, sondern dass man sich mehr damit befasst, was Menschen wollen. Das heißt, was würde denn die Arbeit jeder einzelnen Berufsgruppe, in der was implementiert werden soll, erleichtern? Was ist das, was Menschen gerne haben möchten, um ihren Alltag besser gestalten zu können, wenn man an Pflegekräfte zum Beispiel denkt. Da würde beispielsweise eine viel einfachere Dokumentation von dem, was sie machen, so viel mehr Raum geben für die relevante Arbeit, die sie an anderen Stellen machen. Und das ist mit ganz vielen Jobs so, dass wenn wir erst die Menschen ordentlich fragen, was sind die Aufgaben, die du machst und welche würdest du gerne abgeben? Nicht, welche können wir automatisieren, sondern welche würdest du gerne abgeben, um dann eben mehr an den zentralen Punkten deiner Arbeit, und da kommen wir jetzt in die Arbeitspsychologie, zu arbeiten, die für dich erfüllend sind, sinnstiftend und eben einfach sehr relevant. Ich habe die Hoffnung, dass wir da ein bisschen mehr hinkommen. Ich würde aber sagen, es ist natürlich utopisch von meiner Perspektive. ich Ja, würde es mir aber wünschen. Ich wünsche mir mehr Menschenzentrierung und eben erst den Menschen zu fragen, was sie möchten und dann technische Systeme zu implementieren. Und ich weiß, dass das

00:25:19 SPEAKER_01

das sehr selten der Fall ist. Vielen Dank. Ich finde auch die Forschungseinblicke, die du uns heute mitgebracht hast, können auf jeden Fall einen wichtigen Beitrag dazu leisten, dass es so hoffentlich angepasst wird. Ja, Aileen, vielen Dank für deine interessante Forschungsarbeit und Kenntnisse, die du heute mit uns geteilt hast. Und liebe Zuhörerinnen und Zuhörer, vielen Dank, dass Sie mit uns eingetaucht sind in das spannende Thema Mensch-KI-Interaktion und menschliche Verhaltenskonsequenzen daraus. Ich freue mich, Sie beim nächsten Mal wieder begrüßen zu dürfen.

00:25:53 SPEAKER_00

Der KI-Insights-Podcast ist eine Initiative des Projekts SAKI, der zentralen Anlaufstelle für innovatives Lehren und Lernen interdisziplinärer Kompetenzen der KI der Hochschule Magdeburg-Stendal, gefördert vom Bundesministerium für Bildung und Forschung.